Atlas Cloud 正式接入備受矚目的 GLM-5 模型,進一步拓展平台強大的生成式 AI 版圖。

- 模型定位: 這款由 智譜 AI (ZHIPU AI/Z.ai) 打造的全新旗艦模型,在 GLM-4 系列 堅實的基礎上實現了質的飛躍。憑藉 7440 億參數的 MoE 架構與突破性的 "slime" 後訓練技術,GLM-5 將複雜推理、程式開發及智慧體 (Agentic) 能力推向了新的高度。

- 核心特徵: 專為解決高難度任務而生,旨在輕鬆駕馭複雜系統工程、長程自主智慧體工作流以及深度邏輯問題求解。

- 價格:$0.8/2.56M 輸入/輸出。

核心技術:搭配 Slime 新技術與 MoE 架構,讓模型邏輯更嚴密、程式開發更智慧

7440 億參數 MoE 架構與海量數據基座

GLM-5 在模型規模和數據廣度上實現了量級跨越,奠定了其「開源界巔峰」的基礎。

- 超大規模參數: 模型參數量擴展至 7440 億(啟動參數約 400 億),採用混合專家(MoE)架構。相比 Llama-3 405B 或 DeepSeek-V3,GLM-5 在參數容量上更具優勢,能夠容納更龐大的世界知識。

- 萬億級 Token 訓練: 預訓練數據高達 28.5 Trillion tokens。

- 部署優勢: 透過 AtlasCloud 提供的 相容 OpenAI 格式的 API 直接調用,享受企業級的推理速度。

突破性的「智慧體(Agentic)」系統工程能力

GLM-5 專為處理長程、複雜的系統性任務而設計。

- 長程任務規劃: 針對需要數十步推理的複雜任務(如自動化軟體開發、法律文書撰寫),GLM-5 展現了卓越的穩定性。

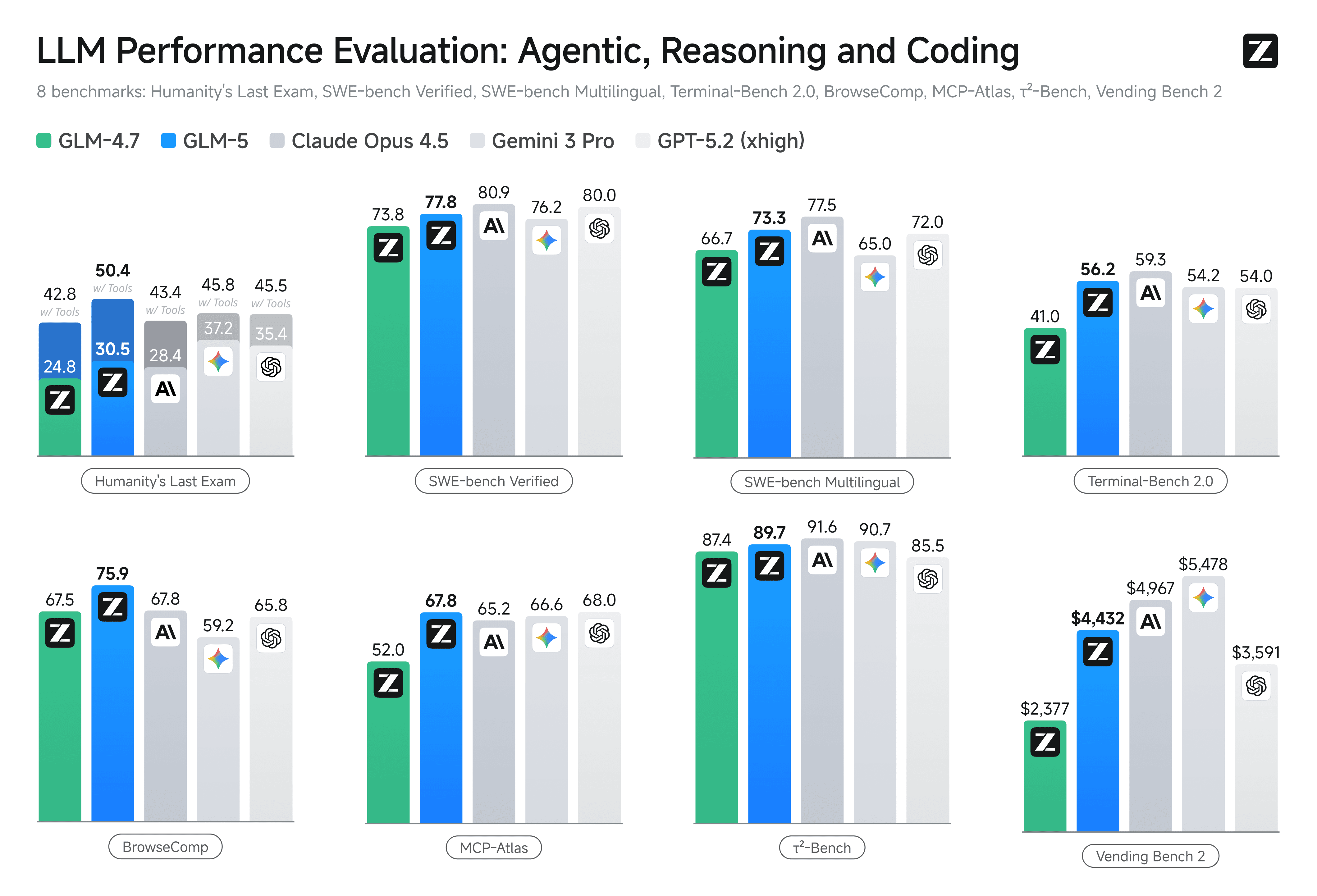

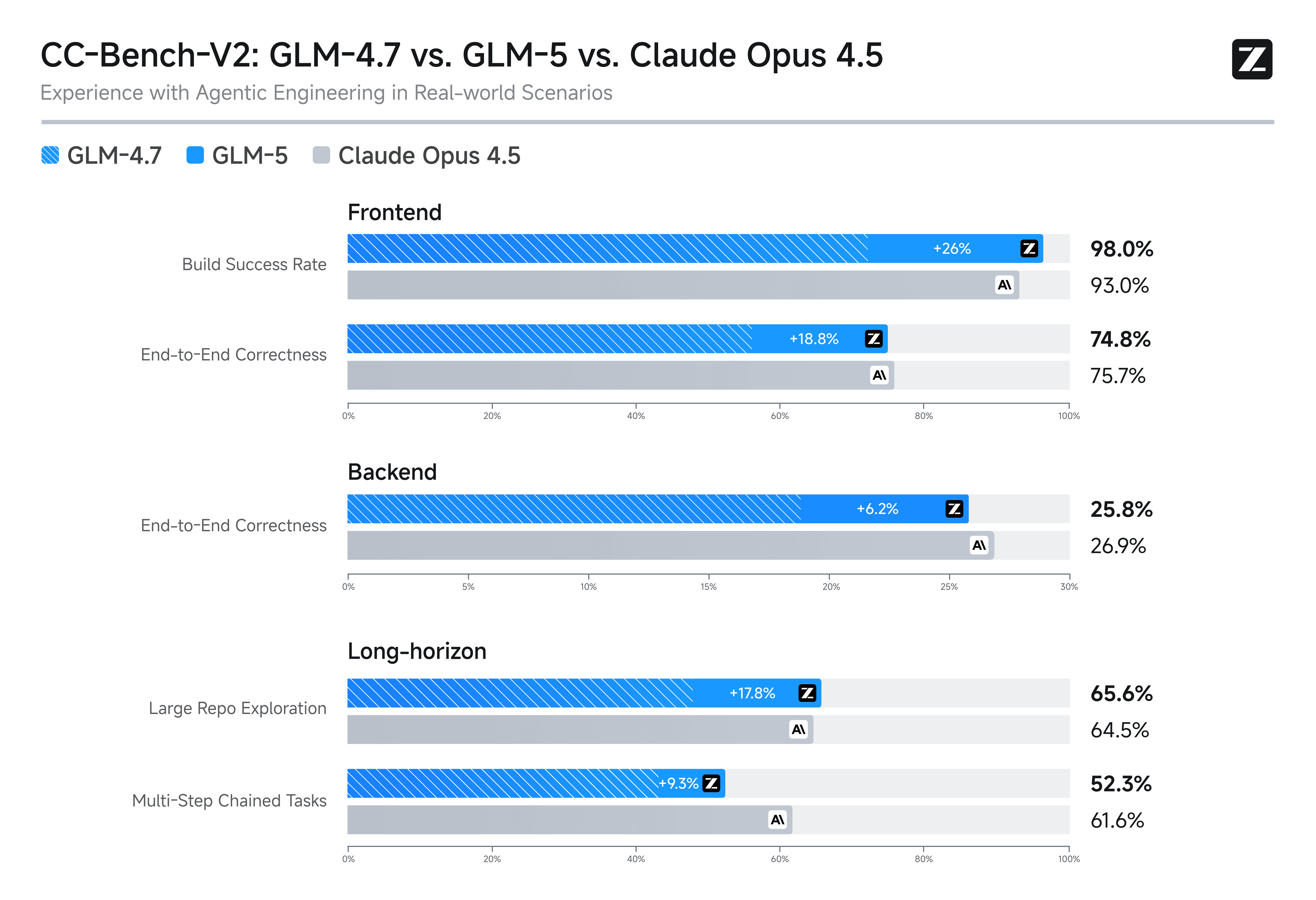

- 競品對比: 在官方評測中,其智慧體能力已大幅縮小了與 Claude Opus 4.5、 Gemini 3 Pro、GPT-5.2(xhigh) 系列等頂尖閉源模型的差距。

- API 應用場景: 對於希望構建自主 AI Agent 的開發者,利用 Atlas Cloud 的高併發 API 接入 GLM-5,可以更低成本地複現類似於 Devin 的自動化程式開發體驗,且無需擔心複雜的模型後端維護。

"Slime" 異步強化學習與程式開發邏輯躍升

智譜 AI 在 GLM-5 中引入了全新的後訓練技術,顯著提升了模型的邏輯嚴密性和程式碼生成品質。

- 技術創新: 引入名為 "Slime" 的異步強化學習(RL)基礎設施,解決了大規模模型後訓練效率低下的痛點。

- 能力對比: 在內部及學術基準測試中,GLM-5 在前端、後端開發及長期規劃任務上大幅超越了前代模型 GLM-4.7,並在開源模型中排名第一。

- 接入便利性: 這種高精度的程式碼和邏輯能力,使其成為程式開發輔助工具的理想後端。透過 Atlas Cloud,用戶可以無縫切換調用 GLM-5 與平台上的其他主流視覺/語言模型(如 Qwen、MiniMax 等)進行對比測試,利用統一的 API 接口快速驗證 GLM-5 在特定業務邏輯中的優越性。

實際應用:自動重構遺留程式碼,像專家一樣深度分析海量研究報告

複雜軟體工程與「遺留程式碼」自動化重構

資深開發者常面臨接手遺留程式碼(文件缺失、邏輯混亂)的痛苦,普通模型因上下文窗口限制或邏輯能力不足,無法理解整個專案倉庫的依賴關係,生成的程式碼往往無法通過編譯或引入新 Bug。

- 全庫級理解與修復: 得益於 GLM-5 強大的 7440 億參數架構與長上下文能力,它不僅能補全程式碼,還能充當「AI 架構師」。用戶可以上傳整個專案庫,讓模型分析模組間的耦合關係,自動規劃並執行跨檔案的重構任務,例如將單體架構拆分為微服務。

- 無縫整合開發環境: 透過 Atlas Cloud 的 API,以極低的遷移成本在本地開發流中接入 GLM-5 的程式碼推理能力,實現從「輔助寫程式」到「自主修 Bug」的質變。

- 端到端測試生成: 針對缺乏測試案例的老舊系統,GLM-5 能根據程式碼邏輯反向推導業務規則並編寫高覆蓋率的單元測試,大幅降低系統維護風險。

深度研究報告分析與跨語種報告綜述

分析師和科研人員每天需要面對海量資訊,LLM 通常難以進行深度推理、交叉驗證數據真實性,且在處理多語言長文件時容易產生「幻覺」或丟失關鍵細節。

- 海量知識庫的深度推理: 基於 28.5T tokens 訓練的 GLM-5 擁有近乎全知的數據儲備。在處理複雜的行業分析時,它不僅能總結資訊,還能指出研究報告中的邏輯漏洞,甚至結合歷史數據推演市場趨勢,提供具有「專家直覺」的洞見,而非簡單的文字堆砌。

- 高併發與低延遲的即時響應: 對於需要即時監控全球輿情的多構,直接部署超大模型成本極高。透過 Atlas Cloud 的高可用 API 服務接入 GLM-5,用戶無需維護昂貴的 GPU 集群,即可利用雲端的彈性算力併發處理數百份多語言文件。

- 結構化數據清洗: GLM-5 卓越的指令遵循能力使其能從非結構化的新聞、文件中精準提取數據(如營收、增長率)。

- (圖示為 GLM-5 生成的 docx 文件)

Atlas Cloud: 使用 GLM-5 的最佳平台

在 AtlasCloud,告別繁瑣的 API 金鑰管理與平台切換。你可以:

怎麼在 Atlas Cloud 使用 GLM-5?

方法一:直接在平台上使用

方法二:接入 API 使用

步驟 1: 獲取你的 API

在控制台中創建並貼上你的 API

步驟 2:查閱 API 文件

請在我們的API 文件中查看接口端點、請求參數及認證方式。

步驟 3:發起您的首次請求(Python 示例)

這裡以 GLM-5 為例

plaintext1import requests 2 3url = "https://api.atlascloud.ai/v1/chat/completions" 4headers = { 5 "Content-Type": "application/json", 6 "Authorization": "Bearer $ATLASCLOUD_API_KEY" 7} 8data = { 9 "model": "zai-org/glm-5", 10 "messages": [ 11 { 12 "role": "user", 13 "content": "what is difference between http and https" 14 } 15 ], 16 "max_tokens": 1024, 17 "temperature": 0.7, 18 "stream": True 19} 20 21response = requests.post(url, headers=headers, json=data) 22print(response.json())