Qwen3-Max-Thinking 簡介

AtlasCloud 正在進一步擴展其生成式 AI 的版圖,即將重磅引入 Qwen3-Max-Thinking:

- 它的定位: 這是由通義千問團隊打造的全新旗艦模型。它在 Qwen 系列 堅實的語言底座之上,引入了革命性的「測試時擴展」(Test-Time Scaling)與原生智能體(Native Agent)架構。

- **核心價值 (Key Benefit)**: 無論是需要深度邏輯推導的數學難題、在海量噪音中還原客觀真相的輿情分析,還是需要自主判斷何時連網、何時撰寫程式碼的自動化任務,Qwen3-Max-Thinking 都能提供超越預期的執行力。

- **當前狀態 (Status)**:震撼上線!

Qwen3-Max-Thinking 將成為全能型 AI 生成領域的下一個規則改變者。它標誌著 AI 正式從「機率生成」向「邏輯推導與自主執行」跨越,讓您在處理最棘手的任務時,也能擁有值得信賴的智慧夥伴。

讓我們透過以下三大核心技術特徵,揭開 Qwen3-Max-Thinking 強大「慢思考」能力的秘密,看看它是如何重新定義智慧上限的。

核心技術突破:TTS 架構與原生智能體的完美融合

基於「測試時擴展」(TTS)的深度推理架構

- 核心機制:不同於傳統的暴力多路採樣(Majority Voting),Qwen3-Max-Thinking 引入了經驗累積式迭代(Iterative Self-Improvement)。在推理過程中,模型能從前序步驟中「提取經驗」,進行多輪自我反思與路徑修正。

- 效果:這種「慢思考」機制使其在處理極難問題時能有效避免重複錯誤,顯著提升了數學(IMO-AnswerBench)和科研級問答(GPQA Diamond)的準確率,被視為從「機率生成」向「邏輯推導」的代際跨越。

- 複雜事實「去噪」能力。在 Reddit 社群的實測中,面對如「2002年世界盃爭議」這類充滿歷史噪音和偏見的話題,Qwen3 能利用深層推理有效過濾無效資訊,在對比不同信源後重構客觀真相,避免了普通模型常見的幻覺或照搬偏見問題。

原生集成的自適應智能體(Adaptive Agent)能力

- 核心機制:模型不再是被動的文本生成器,而是具備自主判斷力的執行者。它能根據對話上下文,主動判斷是否需要「連網搜尋」獲取即時資訊,或調用「程式碼解釋器」進行精確計算,且這一過程是與其推理思維鏈(CoT)無縫融合的。

- 效果:解決了大模型常見的「幻覺」和「計算短板」問題,使其在涉及複雜多步操作的任务中表現出極高的執行力。

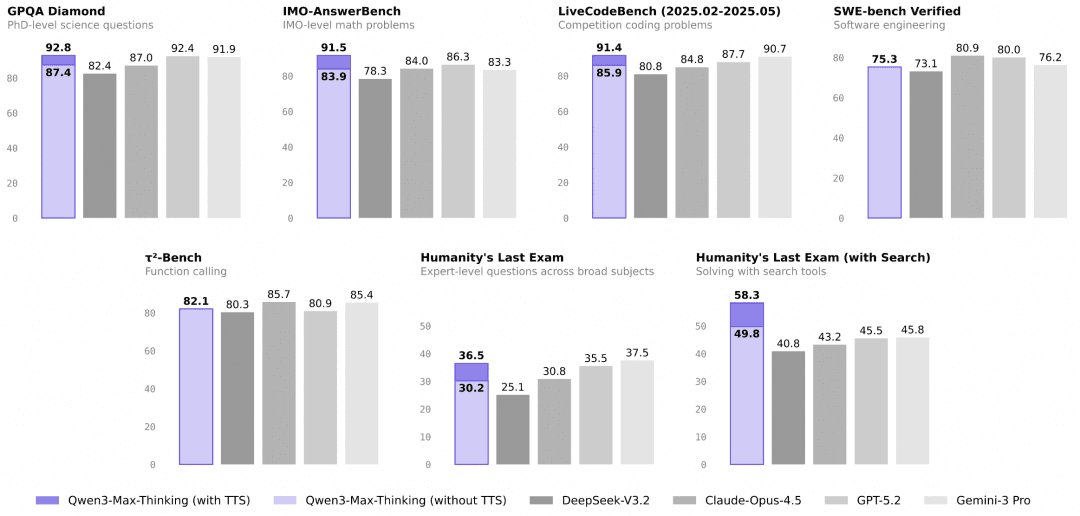

全面超越頂尖競品的基準測試表現(SOTA)

- 核心數據:模型採用超萬億(1T+)參數規模與 36T Token 訓練。最引人注目的是在 Humanity's Last Exam (HLE) 評測中,Qwen3-Max-Thinking 取得了 58.3 的高分,大幅領先 GPT-5.2-Thinking (45.5) 和 Gemini 3 Pro (45.8) 超過 10 分,證明了其在工具調用與複雜場景下的領先地位。

在事實知識、複雜推理、指令遵循、人類偏好對齊以及智能體能力五大維度全面躍升,在 19 項權威基準測試中,其性能已可媲美當前頂尖大模型,如 GPT-5.2-Thinking-xhigh、Claude Opus 4.5 和 Gemini 3 Pro。

Qwen3-Max-Thinking 實戰指南: 三大場景解鎖「專家級」AI 生產力

跑分數據令人印象深刻,但對於 AtlasCloud 的開發者而言,真正的價值在於業務落地。以下實戰場景將帶您領略,如何利用「深度推理」解決那些傳統模型束手無策的難題。

「零試錯」成本的複雜系統重構與除錯

- 核心痛點解決:過去,開發者使用大模型輔助編程,往往是「生成程式碼 -> 執行報錯 -> 把報錯丟回給模型 -> 再生成」。而在 AtlasCloud 上調用 Qwen3-Max-Thinking,可以利用其「深度推理」特性,讓模型在輸出程式碼前先在思維鏈中進行心算。

- 場景示例:重構遺留程式碼

- 面對一段邏輯混亂、缺乏註釋的十年老程式碼,您可以直接要求模型:「分析這段程式碼潛在的風險,並給出一個基於現代異步架構的重構方案,且必須解釋為何新方案能避免原有的競態條件。」

- 得益於 Qwen3 的多輪自我反思機制,它不會像以前的模型那樣直接生成一段似是而非的程式碼,而是會像一位資深架構師一樣,先推演依賴關係,發現邏輯漏洞,自我修正方案,最後才在 AtlasCloud 的終端吐出那個「一次跑通」的完美版本。

真正的「全自動」數據分析員(Text-to-Insight)

- 核心痛點解決:開發者通常需要編寫大量繁瑣的「膠水程式碼」來連接搜尋 API、資料庫和 Python 環境。Qwen3 的原生智能體能力將這一過程變成了「黑盒交付」。

- 場景示例:一句話生成精準行業研報

- 用戶只需輸入一個模糊指令:「幫我分析 2024 年 Q3 東南亞電商市場的異動,並對比我們的內部銷售數據(已上傳 CSV)。」

- 模型會自動拆解任務:您不再需要定義「如果 A 則調用工具 B」的複雜流程圖。模型就是那個懂得「缺什麼數據就自己去找、程式碼報錯了就自己修」的獨立員工,您只需驗收結果。

針對「模糊地帶」的高精度智慧審核與決策

- 核心痛點解決:在內容審核、法律諮詢或複雜客服場景中,傳統的 RAG(檢索增強生成)方案往往因為檢索到的片段相互矛盾(噪音),導致模型胡言亂語。Qwen3 的「去噪」與高分 HLE 表現,使其能處理人類都覺得棘手的灰度問題。

- 場景示例:處理複雜的客訴與合規爭議

- 當用戶投訴一個涉及多方責任的複雜退款問題(如:「商家說發了貨,物流顯示簽收,但我沒收到,且平台規則 A 和規則 B 似乎有衝突」)。

- 普通模型只會機械地複述規則。Qwen3-Max-Thinking 能像法官一樣,提取多方證據中的時間線,識別其中的邏輯矛盾(去噪),並根據上下文權重判斷哪條規則優先適用,最終生成一份既合規又具同理心的處理建議。

- 對於 Atlas Cloud 用戶而言,這意味著您可以將原本必須由人工專家處理的「長尾高難工單」,放心地交給 API 自動化處理,大幅降低營運成本。

無論是重構程式碼還是複雜決策,強大的能力觸手可及。現在,讓我們看看如何在 AtlasCloud 平台上透過簡單的幾步操作,立即啟用這一全新的旗艦模型。

怎麼在 Atlas Cloud 使用 Qwen3-Max-Thinking?

方法一:直接在平台上使用

方法二:接入 API 使用

步驟 1: 獲取您的 API

在控制台中建立並貼上您的 API

步驟 2:查閱 API 文件

請在我們的 API 文件中查看接口端點、請求參數及認證方式。

步驟 3:發起您的首次請求(Python 示例)

這裡以 Qwen3-Max-Thinking 為例

plaintext1import requests 2 3url = "https://api.atlascloud.ai/v1/chat/completions" 4headers = { 5 "Content-Type": "application/json", 6 "Authorization": "Bearer $ATLASCLOUD_API_KEY" 7} 8data = { 9 "model": "qwen/qwen3-max-2026-01-23", 10 "messages": [ 11 { 12 "role": "user", 13 "content": "what is difference between http and https" 14 } 15 ], 16 "max_tokens": 16000, 17 "temperature": 1, 18 "stream": True 19} 20 21response = requests.post(url, headers=headers, json=data) 22print(response.json())