Kimi K2.5 登陆 AtlasCloud:解锁原生视觉、万亿 MoE 架构与蜂群智能

速览

$0.56/2.8M 输入/输出

AtlasCloud上线 Kimi K2.5 :

-

核心定义:Kimi K2.5由 Moonshot AI 开发,通过原生视觉与混合专家架构提升了Kimi 系列的多模态基础。

-

主要效益:适用于复杂视频流分析、自动化代理任务执行及高审美标准的编程开发。

-

当前状态:震撼上线!

Kimi K2 确立了长文本处理领域的行业标准,Kimi K2.5 将凭借其全方位的推理与执行能力推动 AI 生成技术的发展。

01 核心技术突破:原生视觉、蜂群智能与 MoE 高效能架构

Kimi K2.5 展现了从“单一对话”向“全能多模态执行”的质变。

“蜂群思维”与高阶推理能力 (Agentic Intelligence)

Kimi K2.5 突破了传统大模型“单线程思考”的局限,引入了类似生物集群的协作智能。

- 核心解析:

- **Agent Swarm (蜂群代理)**:“自我指导”的并行处理系统。模型可以将一个复杂目标拆解,指挥多达 100个子智能体 并行协作,不仅保留了 Kimi 招牌的“思考模式”,更将其扩展到了任务执行层面。

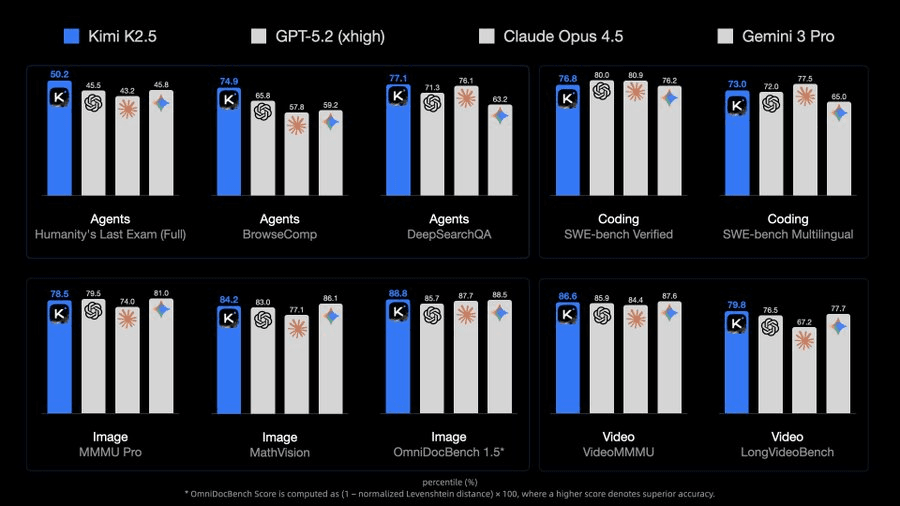

- 复杂任务统治力:在 HLE(人类终极考试,见图片)基准中取得 50.2% 的成绩,证明其在处理长链条、多步骤的复杂指令时,具备了超越以往模型的规划能力。

- 与前代/竞品对比:

- 对比单代理(Single-Agent):执行速度提升 4.5倍,且能处理的任务复杂度远超 Kimi K2 或标准 GPT-4 类模型。

- 对比竞品:在代理能力上超越了当时的顶尖竞品(如模拟环境中的 GPT-5.2 和 Claude 4.5),成为新的全球标杆。

原生视觉与视频直读能力 (Native Multimodal Vision)

- 核心解析:

- 视频即输入:不仅支持用户上传图像,更能直接处理视频流。基于 15T 图文混合数据的预训练,使其能深度分析视频中的动态变化、逻辑关系。

- 这也让它成为 Atlas Cloud 上众多生图生视频模型的最佳搭档——用户可以在平台上让多个视频模型同时跑 Prompt,优选出最佳素材后直接喂给 Kimi 进行分析,无需在多个工具间反复横跳。

- 精准布局解析:能解读“精密的平面布局”,这得益于其原生的多模态架构,使其在 MMMU Pro(78.5%)和 VideoMMMU(86.6%)等视觉基准上实现了开源 SOTA。

- 视频即输入:不仅支持用户上传图像,更能直接处理视频流。基于 15T 图文混合数据的预训练,使其能深度分析视频中的动态变化、逻辑关系。

- 与前代/竞品对比:

- 对比外挂视觉模型:早期的多模态模型往往是“语言模型+视觉编码器”的拼接,而 K2.5 是原生融合,理解更深,不再会有“幻觉”或“理解断层”。

- 对比 Kimi K2:从 K2 的“长文本王者”进化为 K2.5 的“全感官通才”,弥补了纯文本模型的感知短板。

“懂审美”的工程化编程 (Code with Taste)

Kimi K2.5 将编程能力从单纯的“功能实现”提升到了“交互美学”的维度。

- 核心解析:

- 视觉转代码:用户可以直接上传设计图甚至演示视频,K2.5 能将其转化为代码。

- 高阶特效支持:特别强化了对 Three.js 等复杂 3D 库和动态效果的支持。

- 工程实战:在 SWE-bench Verified 中获得 76.8% 的高分,证明其不仅懂花哨的前端,也能处理严肃的后端逻辑。

- 与前代/竞品对比:

- 对比普通代码模型:大多数代码模型(如 CodeLlama)只能保证代码“不报错”,而 K2.5 能保证代码“好看”且“符合视觉逻辑”,这是质的飞跃。

架构革新与跨代性能飞跃 (Architectural Revolution & Generational Leap)

Kimi K2.5 基于 MoE 架构实现了计算效率与智能密度的完美平衡,标志着模型能力从“线性增长”转向“指数级跨越”。

- 核心解析:

- MoE 架构红利:采用 1T 参数的混合专家架构,但在推理时仅激活 32B 参数。

- 这种高能效设计与 Atlas Cloud 的低成本优势完美契合,用户既能在平台上同屏直观对比“生成质量 vs 成本”,用最少的钱跑出最完美的视频或代码,也能利用平台提供的 OpenAI 兼容接口 (API) 轻松接入这一顶级模型。

- 与前代/竞品对比:

- 对比 Kimi K2:如果说 K2 是长文本领域的专家,K2.5 则是在全维度上实现了智能化重构,推理深度与广度呈现爆发式增长。

- 对比传统大模型 API:得益于高效的 MoE 架构,K2.5 在提供同等甚至超越 GPT-4 级别智能的同时,展现出了更具优势的推理效率,是构建高性能 AI 应用的理想基座。

02 开发者实战场景:自动化视频工作流与视觉转代码全链路

Kimi K2.5 的核心能力不仅仅停留在技术参数上,更在于它如何改变开发者的日常工作方式,以下是三个具体的应用方向:

多模态工作流与素材筛选

- 视频深度理解:直接分析视频流内的动态逻辑并省去繁琐的预处理环节。

- 多模型协作:配合平台并行生成的多个视频结果快速筛选出质量最佳的素材。

- 智能成本控制:直观对比不同模型的生成效果与价格以找到最优的投入产出比。

视觉驱动的代码开发

- 设计稿还原:将静态图片或演示视频直接转化为带有 Three.js 动效的前端代码。

- 通用接口接入:利用 OpenAI 兼容接口把这种高级编程能力轻松连入现有的开发工具。

- 高性能推理:借助混合专家架构在极低的延迟下处理复杂的生产级代码逻辑。

大规模自动化代理集群

- 蜂群并行执行:将大任务拆解给上百个子智能体同时处理以大幅提升完成速度。

- 长程逻辑规划:在执行多步骤的复杂任务时保持极其稳定的逻辑连贯性。

- 高并发处理:依托平台的高并发设施运行大规模代理网络并实现业务流程自动化。

现在,让我们看看如何在 AtlasCloud 上快速配置好这一切。

03 Atlas Cloud: 驾驭 Kimi K2.5 的最佳平台

Atlas Cloud 核心优势预览

成本效益与极致速度

- 极具竞争力的定价策略:通过优化的性价比提供最具成本效益的生成体验。

- 加速推理与生成:以更快的响应速度支持高频次的项目迭代与快速交付。

工作流集成与 API 生态 专为无缝融入技术开发管线及支持下游任务而设计。

- 灵活的协同工作流:支持与其他生成式模型在同一环境中并行协作。

- 高可用性交付物:生成结果便于直接进行即时后处理或二次编辑。

- 全功能 API 接入:提供标准开发者接口以实现业务流程自动化与应用深度集成。

怎么在 Atlas Cloud 上使用?

方法一:直接在平台上使用

方法二:接入API使用

步骤 1: 获取你的API

在控制台中创建并粘贴你的API

步骤 2:查阅 API 文档

请在我们的 API 文档中查看接口端点、请求参数及认证方式。

步骤 3:发起您的首次请求(Python 示例)

plaintext1import requests 2 3# Vision Understanding Example 4# Image: Use base64 encoding (data:image/png;base64,...) 5# Video: Use URL (recommended for large files) 6 7url = "https://api.atlascloud.ai/v1/chat/completions" 8headers = { 9 "Content-Type": "application/json", 10 "Authorization": "Bearer $ATLASCLOUD_API_KEY" 11} 12data = { 13 "model": "moonshotai/kimi-k2.5", 14 "messages": [ 15 { 16 "role": "user", 17 "content": [ 18 { 19 "type": "image_url", 20 "image_url": { 21 "url": "data:image/png;base64,<BASE64_IMAGE_DATA>" 22 } 23 }, 24 { 25 "type": "video_url", 26 "video_url": { 27 "url": "https://example.com/your-video.mp4" 28 } 29 }, 30 { 31 "type": "text", 32 "text": "Please describe the content of this image/video" 33 } 34 ] 35 } 36 ], 37 "max_tokens": 32768, 38 "temperature": 1, 39 "stream": True 40} 41 42response = requests.post(url, headers=headers, json=data) 43print(response.json())