Qwen3-Max-Thinking简介

AtlasCloud 正在进一步扩展其生成式 AI 的版图,即将重磅引入 Qwen3-Max-Thinking:

- 它的定位: 这是由通义千问团队打造的全新旗舰模型。它在 Qwen 系列 坚实的语言底座之上,引入了革命性的“测试时扩展”(Test-Time Scaling)与原生智能体(Native Agent)架构。

- 核心价值 (Key Benefit): 无论是需要深度逻辑推导的数学难题、在海量噪音中还原客观真相的舆情分析,还是需要自主判断何时联网、何时写代码的自动化任务,Qwen3-Max-Thinking 都能提供超越预期的执行力。

- 当前状态 (Status):震撼上线!

Qwen3-Max-Thinking 将成为全能型 AI 生成领域的下一个规则改变者。它标志着 AI 正式从“概率生成”向“逻辑推导与自主执行”跨越,让您在处理最棘手的任务时,也能拥有值得信赖的智能伙伴。

让我们通过以下三大核心技术特征,揭开 Qwen3-Max-Thinking 强大“慢思考”能力的秘密,看看它是如何重新定义智能上限的。

核心技术突破:TTS 架构与原生智能体的完美融合

基于“测试时扩展”(TTS)的深度推理架构

- 核心机制:不同于传统的暴力多路采样(Majority Voting),Qwen3-Max-Thinking 引入了经验累积式迭代(Iterative Self-Improvement)。在推理过程中,模型能从前序步骤中“提取经验”,进行多轮自我反思与路径修正。

- 效果:这种“慢思考”机制使其在处理极难问题时能有效避免重复错误,显著提升了数学(IMO-AnswerBench)和科研级问答(GPQA Diamond)的准确率,被视为从“概率生成”向“逻辑推导”的代际跨越。

- 复杂事实“去噪”能力。在 Reddit 社区的实测中,面对如“2002年世界杯争议”这类充满历史噪音和偏见的话题,Qwen3 能利用深层推理有效过滤无效信息,在对比不同信源后重构客观真相,避免了普通模型常见的幻觉或照搬偏见问题。

原生集成的自适应智能体(Adaptive Agent)能力

- 核心机制:模型不再是被动的文本生成器,而是具备自主判断力的执行者。它能根据对话上下文,主动判断是否需要“联网搜索”获取实时信息,或调用“代码解释器”进行精确计算,且这一过程是与其推理思维链(CoT)无缝融合的。

- 效果:解决了大模型常见的“幻觉”和“计算短板”问题,使其在涉及复杂多步操作的任务中表现出极高的执行力。

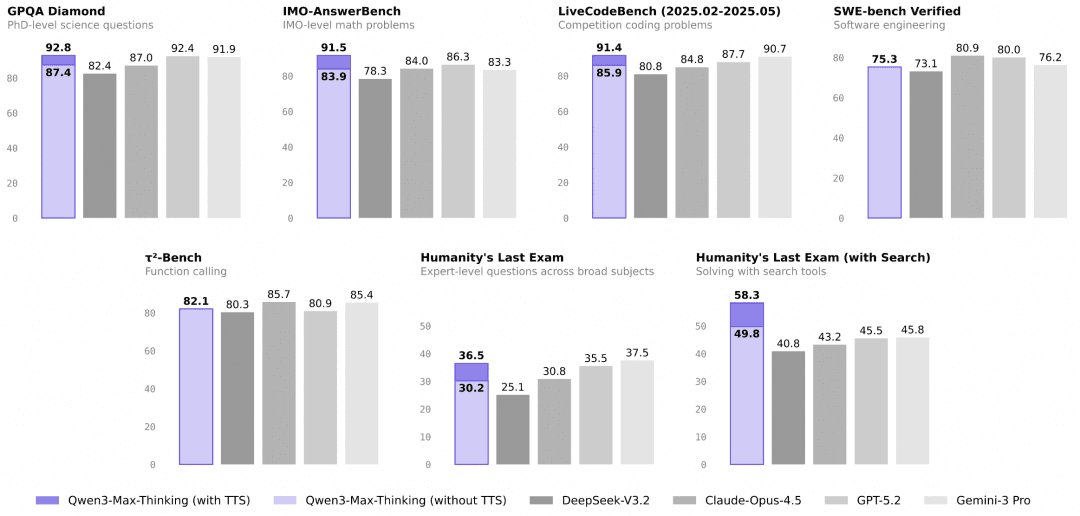

全面超越顶尖竞品的基准测试表现(SOTA)

- 核心数据:模型采用超万亿(1T+)参数规模与 36T Token 训练。最引人注目的是在 Humanity's Last Exam (HLE) 评测中,Qwen3-Max-Thinking 取得了 58.3 的高分,大幅领先 GPT-5.2-Thinking (45.5) 和 Gemini 3 Pro (45.8) 超过 10 分,证明了其在工具调用与复杂场景下的领先地位。

在事实知识、复杂推理、指令遵循、人类偏好对齐以及智能体能力五大维度全面跃升,在 19 项权威基准测试中,其性能已可媲美当前顶尖大模型,如 GPT-5.2-Thinking-xhigh、Claude Opus 4.5 和 Gemini 3 Pro。

Qwen3-Max-Thinking 实战指南: 三大场景解锁“专家级”AI 生产力

跑分数据令人印象深刻,但对 AtlasCloud 的开发者而言,真正的价值在于业务落地。以下实战场景将带您领略,如何利用“深度推理”解决那些传统模型束手无策的难题。

“零试错”成本的复杂系统重构与除虫

- 核心痛点解决:过去,开发者使用大模型辅助编程,往往是“生成代码 -> 运行报错 -> 把报错扔回给模型 -> 再生成”。而在 AtlasCloud 上调用 Qwen3-Max-Thinking,可以利用其“深度推理”特性,让模型在输出代码前先在思维链中进行心算。

- 场景示例:重构遗留代码

- 面对一段逻辑混乱、缺乏注释的十年老代码,您可以直接要求模型:“分析这段代码潜在的风险,并给出一个基于现代异步架构的重构方案,且必须解释为何新方案能避免原有的竞态条件。”

- 得益于 Qwen3 的多轮自我反思机制,它不会像以前的模型那样直接生成一段似是而非的代码,而是会像一位资深架构师一样,先推演依赖关系,发现逻辑漏洞,自我修正方案,最后才在 AtlasCloud 的终端吐出那个“一次跑通”的完美版本。

真正的“全自动”数据分析员(Text-to-Insight)

- 核心痛点解决:开发者通常需要编写大量繁琐的“胶水代码”来连接搜索 API、数据库和 Python 环境。Qwen3 的原生智能体能力将这一过程变成了“黑盒交付”。

- 场景示例:一句话生成精准行业研报

- 用户只需输入一个模糊指令:“帮我分析 2024 年 Q3 东南亚电商市场的异动,并对比我们的内部销售数据(已上传 CSV)。”

- 模型会自动拆解任务:您不再需要定义“如果A则调用工具B”的复杂流程图。模型就是那个懂得“缺什么数据就自己去找、代码报错了就自己修”的独立员工,您只需验收结果。

针对“模糊地带”的高精度智能审核与决策

- 核心痛点解决:在内容审核、法律咨询或复杂客服场景中,传统的 RAG(检索增强生成)方案往往因为检索到的片段相互矛盾(噪音),导致模型胡言乱语。Qwen3 的“去噪”与高分 HLE 表现,使其能处理人类都觉得棘手的灰度问题。

- 场景示例:处理复杂的客诉与合规争议

- 当用户投诉一个涉及多方责任的复杂退款问题(如:“商家说发了货,物流显示签收,但我没收到,且平台规则A和规则B似乎有冲突”)。

- 普通模型只会机械地复述规则。Qwen3-Max-Thinking 能像法官一样,提取多方证据中的时间线,识别其中的逻辑矛盾(去噪),并根据上下文权重判断哪条规则优先适用,最终生成一份既合规又具同理心的处理建议。

- 对于 Atlas Cloud 用户而言,这意味着您可以将原本必须由人工专家处理的“长尾高难工单”,放心地交给 API 自动化处理,大幅降低运营成本。

无论是重构代码还是复杂决策,强大的能力触手可及。现在,让我们看看如何在 AtlasCloud 平台上通过简单的几步操作,立即启用这一全新的旗舰模型。

怎么在 Atlas Cloud 使用Qwen3-Max-Thinking?

方法一:直接在平台上使用

方法二:接入API使用

步骤 1: 获取你的API

在控制台中创建并粘贴你的API

步骤 2:查阅 API 文档

请在我们的 API 文档中查看接口端点、请求参数及认证方式。

步骤 3:发起您的首次请求(Python 示例)

这里以Qwen3-Max-Thinking为例

plaintext1import requests 2 3url = "https://api.atlascloud.ai/v1/chat/completions" 4headers = { 5 "Content-Type": "application/json", 6 "Authorization": "Bearer $ATLASCLOUD_API_KEY" 7} 8data = { 9 "model": "qwen/qwen3-max-2026-01-23", 10 "messages": [ 11 { 12 "role": "user", 13 "content": "what is difference between http and https" 14 } 15 ], 16 "max_tokens": 16000, 17 "temperature": 1, 18 "stream": True 19} 20 21response = requests.post(url, headers=headers, json=data) 22print(response.json())