Wan 2.6 vs Sora 2:2025年视频AI大战

引言

2025年末,AI视频领域由两个旗舰模型主导:

两者都能生成令人惊叹的视频,但它们针对的目标截然不同。如果您在问:

- "Wan 2.6 vs Sora 2 — 哪个更适合用于广告?"

- "哪个模型更适合创作宏大、电影感的世界?"

- "如何在一个地方测试两者并将它们集成到我的产品中?"

本指南将提供一个实用的、面向制作的比较,并展示Atlas Cloud如何让您在一个平台上试用这两个模型,并通过单一API进行集成。

摘要:快速比较(规格与定价概览)

Wan 2.6 vs Sora 2一览

| Wan 2.6 | Sora 2 | |

|---|---|---|

| 价格 | Atlas Cloud 上 $0.08/秒 | Atlas Cloud 上 $0.05/秒 |

| 核心关注点 | 角色控制与故事创作 | 世界模拟与商业及电影视频 |

| 标准时长 | 5秒;10秒;15秒 | 10秒;15秒 |

| 输入类型 | 文本到视频;图像到视频;视频参考 | 文本到视频;图像到视频 |

| 尺寸 | 文本到视频和视频参考: 720_1280;1280_720;960_960;1088_832;832_1088;1920_1080;1080_1920;1440_1440;1632_1248;1248_1632;图像到视频: 根据参考图像尺寸。 | 720_1280;1280_720 |

| 分辨率 | 720P,1080P | —— |

| 优势 | 多镜头叙事,面部稳定性,电影级镜头路径 | 深度物理模拟,复杂环境 |

| 音频 | 叙事与对话 | 沉浸式背景音景 |

| 最适合 | 角色动画,社交媒体内容,快速创意构思 | 广告,电商,电影制作,专业制作 |

| 语义外推 | 擅长电影场景 | 擅长商业广告 |

| 镜头构图 | 智能提示执行 | 提示遵循性 |

| 一致性 | 角色一致性 | 环境一致性 |

在 Atlas Cloud上,您可以:

- 使用相同的提示分别运行Wan 2.6和Sora 2

- 并排查看输出质量与成本

- 决定哪个模型能为您的特定工作流程带来最佳投资回报率

模型概述

Wan 2.6 简介

阿里巴巴云的Wan 2.6拥有突破性的多模态能力和原生音频同步功能。最新的Wan 2.6更新通过先进的文本到视频和图像到视频工具赋能创作者,可生成长达15秒的1080p电影级内容。

核心亮点:

- 智能分镜(多镜头叙事)

理解镜头边界,并在特写、中景和远景中保持相同的角色身份。非常适合广告和故事板,其中主角必须保持一致。

- 15秒高保真片段

将视频时长推至约15秒。足以完成一个完整叙事段落——铺垫 → 行动 → 反响——在一次生成中完成,这完美契合6-15秒的广告时段和社交媒体传播。

- 高保真音频与稳定的多人对话

在原生音频生成方面取得了重大飞跃。Wan 2.6提供超逼真的声纹,并支持稳定的多人对话。它能创建同步、自然的跨角色对话,消除AI音频中常见的机械感。

- 高级视频参考(参考指导表演)

上传一段排练视频(手机录制),Wan 2.6会将时机、走位和肢体语言克隆到一个生成的角色身上。这让导演无需重拍就能获得演员级别的控制力。

总而言之,Wan 2.6感觉像是一个全面的叙事引擎,为导演们提供服务,将智能的多镜头视觉效果与高保真对话融为一体,交付完整的、15秒的电影级故事情节。

Sora 2 简介

Sora 2是一款先进的视频生成模型,在物理准确性、真实感和可控性方面显著优于现有系统,是世界模拟的强大引擎。

核心亮点

- 无与伦比的真实感与物理模拟

Sora 2具备先进的世界模拟能力,使生成的场景更严格地遵循物理定律。它擅长在各种美学风格中呈现高保真视觉效果,从超现实、电影级画面到独特的动漫风格。

- 卓越的可控性与一致性

该系统提供前所未有的控制力,能够遵循跨越多个镜头的复杂指令。至关重要的是,它能准确维持"世界状态"(持久性),确保物体、角色和环境在复杂序列中保持一致。

- 完全同步的音频集成

Sora 2超越了静态图像,引入了同步对话和音效。它创建了复杂的背景音景、语音和SFX,并具有高度的真实感,与屏幕上的动作完美匹配,实现完全沉浸式的体验。

- 现实世界集成

该模型允许用户直接将现实世界元素注入生成内容,从而弥合虚拟与现实之间的差距。

总之,Sora 2是一款高保真的世界模拟器,旨在通过高度可控的指令生成物理上一致、多风格的视频,并带有完全同步的音频。

核心差异

一致性焦点:角色 vs. 世界

- Wan 2.6: 其优势在于角色一致性和口型同步。它在跨帧保持角色身份稳定以及完美匹配说话口型方面表现出色。

- Sora 2: 其超能力在于环境一致性。它维持一个稳定、持久的世界状态,确保背景、物理和空间关系在镜头移动时保持连贯。

电影制作与工作流程

根据用例,工作流程体验存在显著差异。

- 通用场景:

- Wan 2.6(创作): 适用于简单的自然语言。您描述氛围,它为您"创造"场景。它依赖生成式直觉。

- Sora 2(制作): 需要更精细化的控制。您需要像导演一样,提供具体的镜头和场景指令(例如,推、拉)。这更像一个技术性的"制作"过程。

- 商业场景:

- Sora 2: 令人惊讶的是,在商业场景中,Sora 2展现出高级别的概念推理能力。它能够智能地生成复杂的广告故事板和镜头,而无需微观管理。

音频动态

- Wan 2.6: 侧重于叙事。它会根据生成的角色自主设计角色对话。

- Sora 2: 侧重于沉浸感。它会根据物理环境生成超逼真的环境音频和背景音景。

结论:创作 vs. 制作

最终,选择取决于两种截然不同的哲学:

- Wan 2.6 适用于"创作"角色: 它像一个直观的创意伙伴,优先考虑演员及其表演。

- Sora 2 适用于"制作"世界: 它像一个高保真的模拟器,优先考虑物理环境和精确的电影控制。

用例:何时/谁选择 Wan 2.6 或 Sora 2

(相同提示,不同输出)

一个有用的决定方法是想象将相同的创意简报输入两个模型,然后比较输出。

示例1:电影级奇幻场景

plaintext1提示: 2一段电影级的科幻预告片。镜头1:广角镜头,一个穿着破旧宇航服的孤独探险家走在荒凉的红色火星沙漠上,远处有一个巨大的废弃飞船。镜头2:特写镜头,探险家停下脚步,擦去头盔面罩上的灰尘,眼中露出震惊。镜头3:过肩镜头,展示一朵在他们面前迅速绽放的、发光的、生物荧光的蓝色花朵。8k分辨率,高度细节,角色一致。

输出:

- Wan 2.6 输出 (点击此处观看输出视频)

- 跨角度的一致性女演员

- 良好的提示指令遵循性

- 沉浸式背景音景

- Sora 2 ((点击此处观看输出视频))

- 良好的提示指令遵循性

- 沉浸式背景音景和对话

示例2:15秒产品广告

plaintext1提示:一位YouTuber推广这款AI伴侣玩具,英语。1280*720

输出:

- Wan 2.6 ((点击此处观看输出视频))

- Sora 2 ((点击此处观看输出视频))

- 在商业场景中出色的语义外推能力

- 保持出色的制作一致性

示例3:动漫风格

在此案例中,您可以清楚地看到Wan 2.6在对话和自动场景检测方面的进步,而Sora 2在沉浸式背景音景方面表现出色。

plaintext1提示: 2高质量动漫风格。一位穿着色彩鲜艳的印花浴衣的女孩,站在夜晚传统的神社台阶上。她回头看向镜头,露出温柔的微笑。巨大、鲜艳的烟花在她身后的黑暗天空中爆炸,照亮了她的剪影。悬挂的纸灯笼散发柔和的光芒。萤火虫,魔法氛围。

输出:

- Wan 2.6 ((点击此处观看输出视频))

- 卓越的AI故事板制作能力

- 流畅的叙事与自然对话

- Sora 2 ((点击此处观看输出视频))

- 沉浸式背景音景

谁应该选择哪个?

- 影响者/普通创作者/追求快速病毒式传播内容的、需要灵活视频尺寸的用户 → Wan 2.6

- 需要精美效果和控制力的专业创作者和品牌/电商 → Sora 2

如何在 Atlas Cloud 上使用两个模型

Atlas Cloud 不会强制您选择"Wan 2.6 vs Sora 2",而是让您并排使用这两个模型——首先在试用环境中,然后通过统一的API。

方法1:直接在 Atlas Cloud 平台使用

方法2:通过API访问

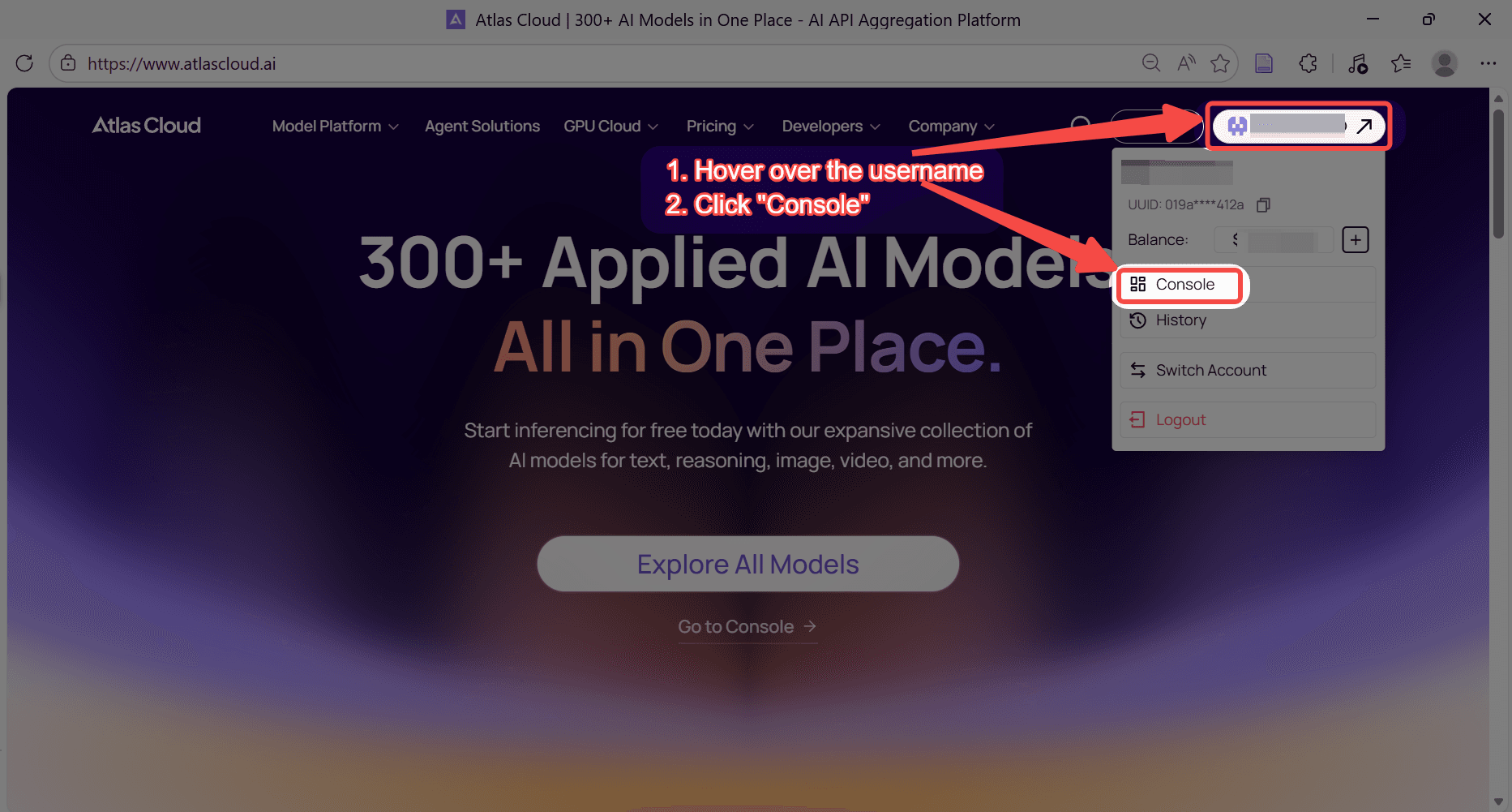

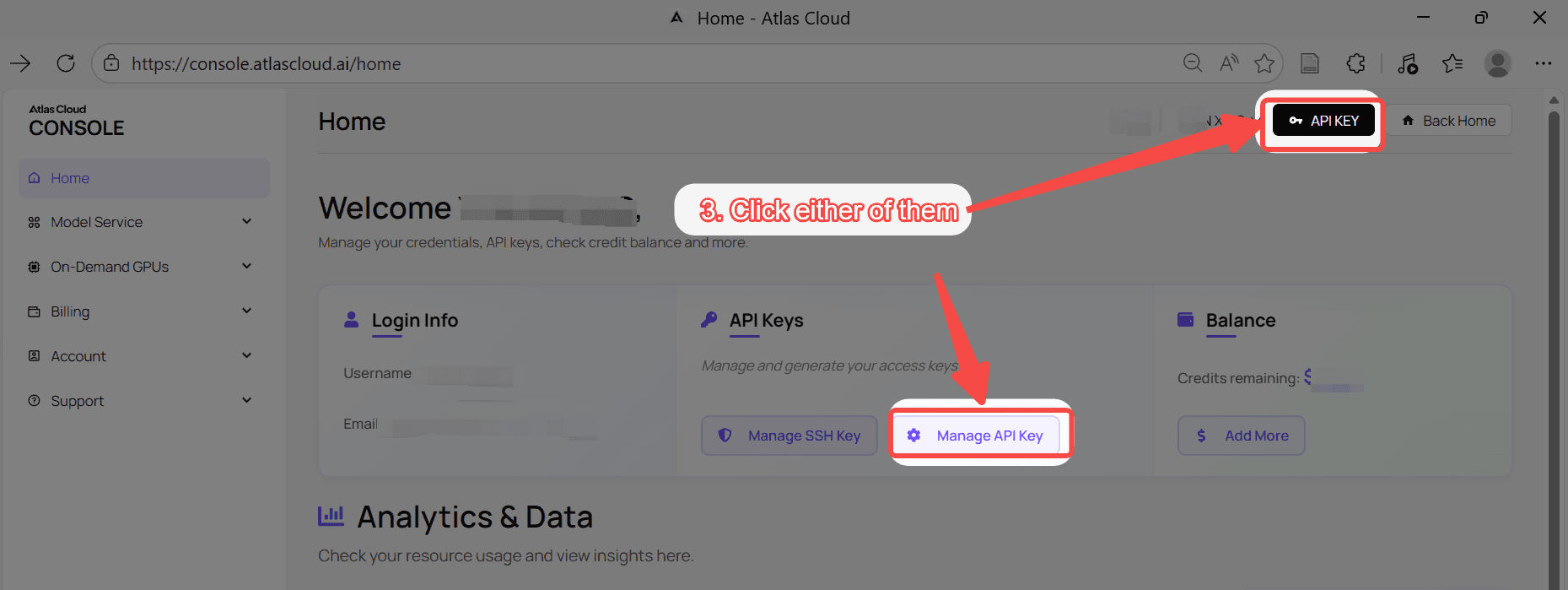

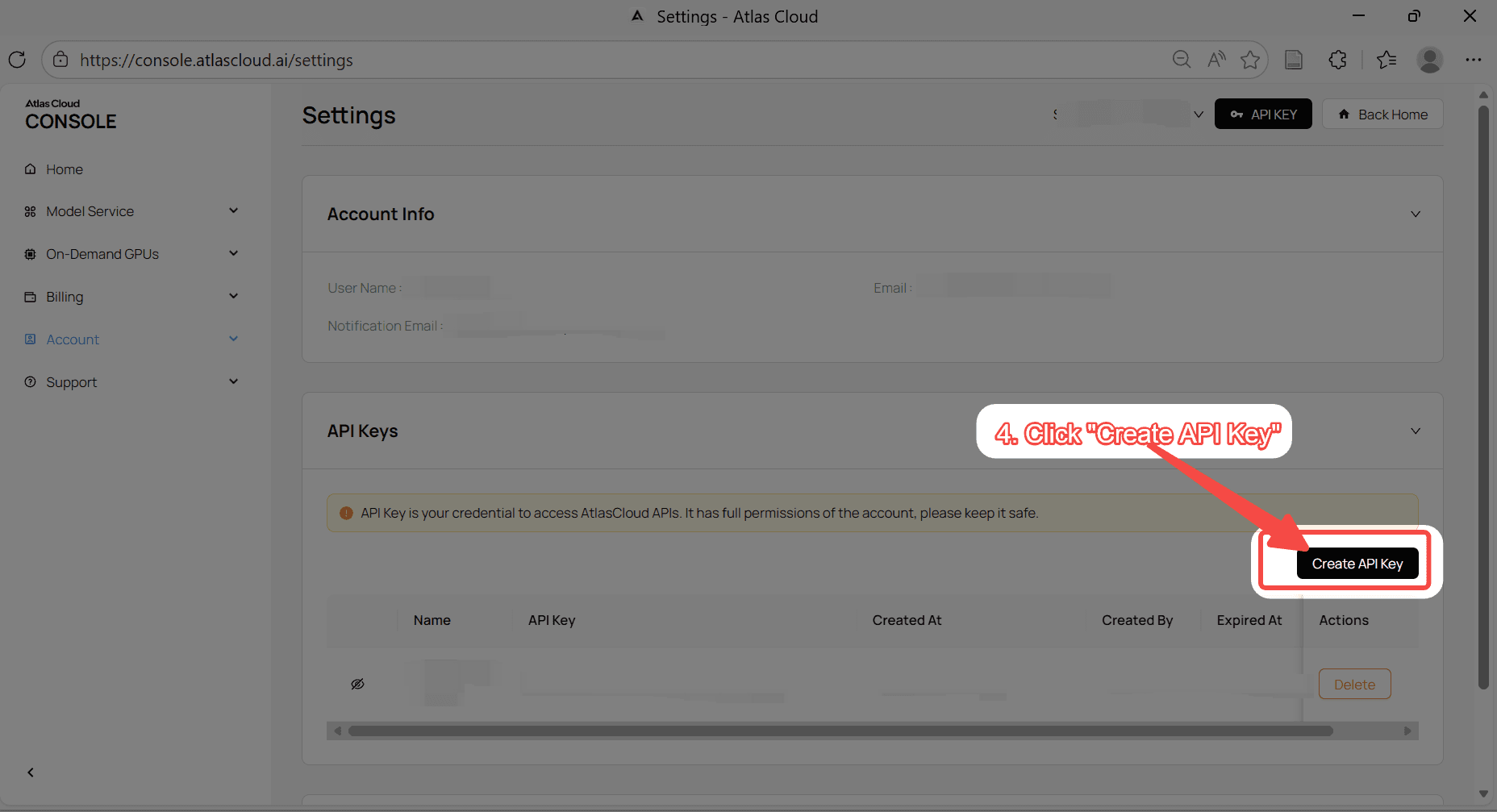

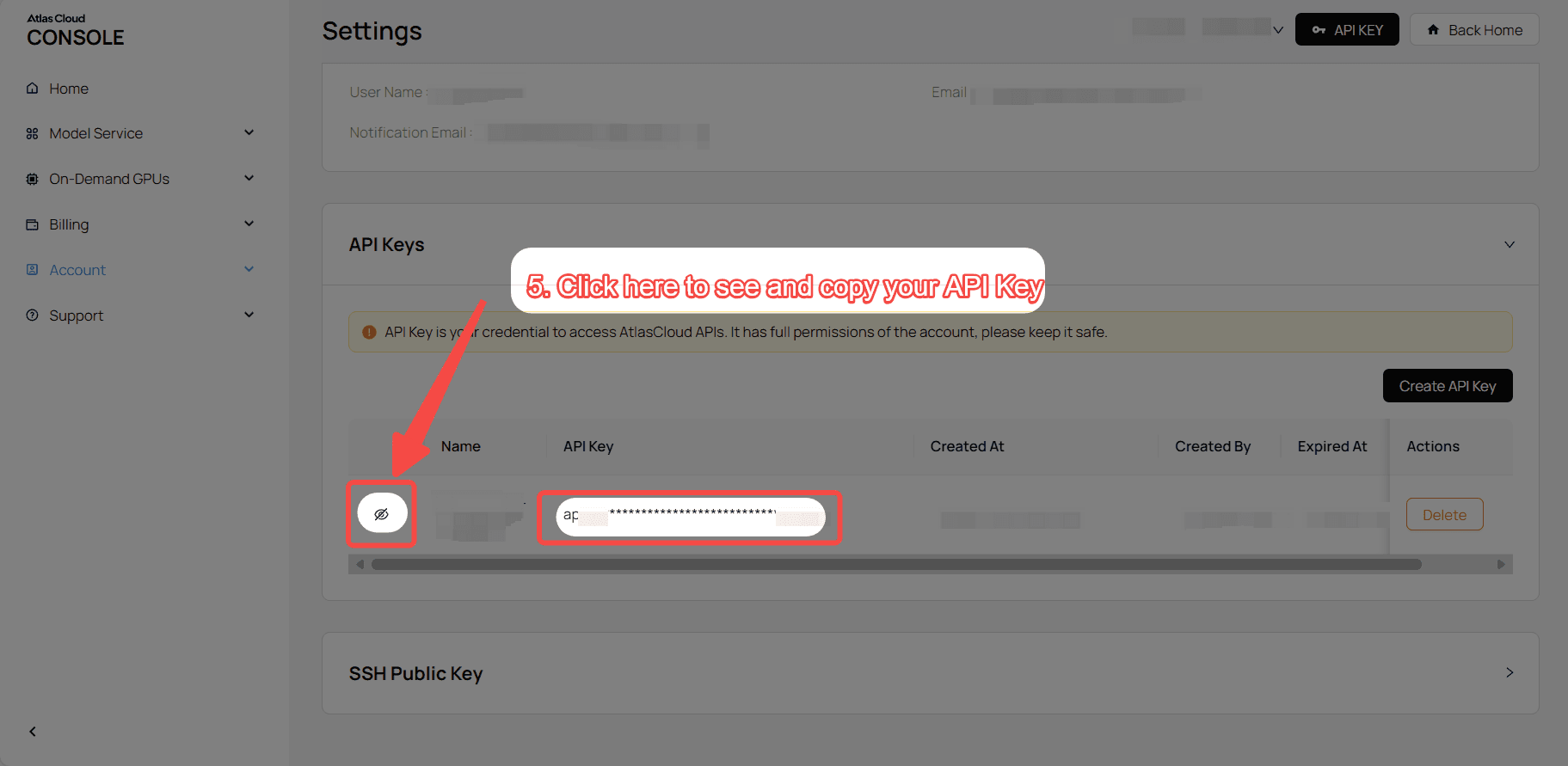

第一步:获取您的API密钥

在您的控制台创建API密钥并复制以备后用。

第二步:查看API文档

在我们的API文档中查阅端点、请求参数和身份验证方法。

第三步:发起您的第一个请求(Python示例)

示例:使用Wan 2.6生成视频(文本到视频)。

python1import requests 2import time 3 4# Step 1: Start video generation 5generate_url = "https://api.atlascloud.ai/api/v1/model/generateVideo" 6headers = { 7 "Content-Type": "application/json", 8 "Authorization": "Bearer $ATLASCLOUD_API_KEY" 9} 10data = { 11 "model": "alibaba/wan-2.6/text-to-video", 12 "audio": None, 13 "duration": 15, 14 "enable_prompt_expansion": True, 15 "negative_prompt": "example_value", 16 "prompt": "A cinematic sci-fi trailer. Shot 1: Wide shot, a lonely explorer in a battered spacesuit walking across a desolate red Martian desert, a massive derelict spaceship in the distance. Shot 2: Close-up, the explorer stops and wipes dust off their helmet visor, eyes widening in shock. Shot 3: Over-the-shoulder shot, revealing a glowing, bioluminescent blue flower blooming rapidly in front of them. 8k resolution, highly detailed, consistent character.", 17 "seed": -1, 18 "size": "1920*1080", 19 "shot_type": "multi" 20} 21 22generate_response = requests.post(generate_url, headers=headers, json=data) 23generate_result = generate_response.json() 24prediction_id = generate_result["data"]["id"] 25 26# Step 2: Poll for result 27poll_url = f"https://api.atlascloud.ai/api/v1/model/prediction/{prediction_id}" 28 29def check_status(): 30 while True: 31 response = requests.get(poll_url, headers={"Authorization": "Bearer $ATLASCLOUD_API_KEY"}) 32 result = response.json() 33 34 if result["data"]["status"] in ["completed", "succeeded"]: 35 print("Generated video:", result["data"]["outputs"][0]) 36 return result["data"]["outputs"][0] 37 elif result["data"]["status"] == "failed": 38 raise Exception(result["data"]["error"] or "Generation failed") 39 else: 40 # Still processing, wait 2 seconds 41 time.sleep(2) 42 43video_url = check_status()

FAQ

问:Atlas Cloud 如何帮助我选择 Wan 2.6 和 Sora 2? 答: Atlas Cloud 允许您同时使用完全相同的提示运行这两个模型。您可以并排查看输出质量和成本,从而确定哪个模型能为您的特定工作流程提供最佳投资回报率(ROI)。

问:两个模型之间根本区别是什么? 答: 核心理念不同:**Wan 2.6 旨在"创作"**,充当一个直观的创意伙伴,专注于角色和叙事表演。**Sora 2 旨在"制作"**,充当一个高保真的模拟器,专注于物理准确性、环境一致性和精确的电影控制。

问:哪个模型在音频处理方面更好? 答: 两者都支持音频,但侧重点不同:

- Wan 2.6: 侧重于叙事。它非常擅长生成自然、同步的跨角色对话,避免了机械的音调。

- Sora 2: 侧重于沉浸感。它生成超逼真的背景音景和音效(SFX),这些音效与屏幕上的物理动作完美匹配。